方式一:直接在根目录下robos.txt文件里面屏蔽掉相关垃圾蜘蛛

见👉robots.txt笔记,但是效果不大,防君子不防小人

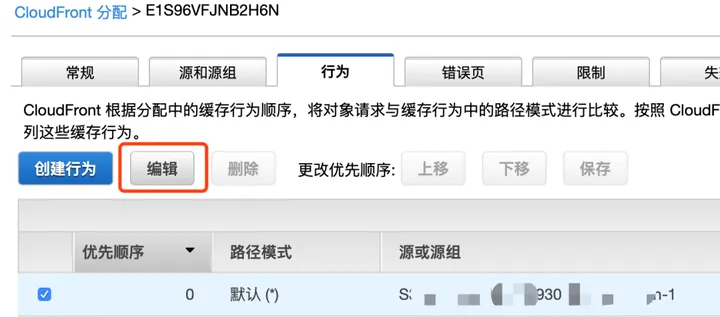

方式二:防火墙里加过滤规则

可以在服务器官方,或者宝塔面板等地方添加,具体查看👉浏览器ua介绍和常见爬虫屏蔽

方式三:宝塔面板网站设置——配置文件,将需要屏蔽的蜘蛛写进配置文件代码里

#屏蔽垃圾蜘蛛

if ($http_user_agent ~* (SemrushBot|DotBot|MJ12bot|AhrefsBot|MauiBot|MegaIndex.ru|BLEXBot|ZoominfoBot|ExtLinksBot|hubspot|leiki|webmeup)) {

return 403;

}